Démocratie et citoyenneté

Thaima Samman,

Benjamin De Vanssay

-

Versions disponibles :

FR

ENThaima Samman

Avocate aux barreaux de Paris et de Bruxelles, fondatrice du cabinet Samman.

Benjamin De Vanssay

Avocat au barreau de Bruxelles

Le règlement sur l'intelligence artificielle (ci-après, « Acte sur l’IA ») est le texte législatif européen de référence dans ce domaine (ci-après, « IA »). L'un de ses principaux objectifs est de réglementer l’usage de cette technologie dans un certain nombre de domaines en suivant une approche fondée sur les risques. Il fixe des obligations graduelles pour les différentes parties impliquées dans la chaîne de valeur de l'IA en fonction du niveau de risque que l'utilisation de celle-ci soulève dans des cas d'utilisation concrets. C’est une législation ciblée portant sur certains aspects de l’IA et non une législation transversale comme peut l’être le règlement général sur la protection des données (ci-après, « RGPD »). Il a été adopté par les colégislateurs en mai 2024 et entrera en vigueur 20 jours après sa publication au Journal officiel de l’Union européenne le 12 juillet . Il sera applicable à partir du 2 août 2026.

La Commission a lancé, en parallèle, le Pacte sur l’IA, invitant les fournisseurs d'IA à anticiper leur conformité aux principales obligations de l’Acte.

1. L’Acte sur l'IA : Nouvelle pièce du puzzle règlementaire de l’IA

L’Acte sur l'IA s'inscrit dans un cadre réglementaire plus large, que l'on peut schématiser comme suit :

- Plusieurs textes ont été adoptés sur les données, ces dernières années, avec deux approches différentes : d'une part, l’encadrement et la restriction de l’accès aux données, essentiellement les données personnelles avec le RGPD ou la Directive e-Privacy, afin de protéger la vie privée des individus, comprenant notamment des garanties spécifiques sur les méthodes de profilage ; d'autre part, l’accroissement du partage et de la disponibilité de tout type de données afin de favoriser l'innovation, avec plusieurs initiatives et textes législatifs, dont le règlement sur les données, le règlement sur la gouvernance des données, les règlements sur les espaces européens de données et la directive sur les informations du secteur public.

- Plusieurs initiatives ont été lancées pour renforcer les capacités d'infrastructure de l'Union, en vue de stimuler l'innovation dans le domaine de l'IA, telles que le nuage européen pour la science ouverte (European Open Science Cloud EOSC), Quantum Flagship et l'Entreprise commune pour le calcul à haute performance européen (EuroHPC). La stratégie européenne pour les données (en particulier le règlement sur le libre flux des données et le règlement sur les données) vise également à stimuler la concurrence dans le domaine du cloud computing et à garantir la sécurité du stockage des données.

- L’Acte sur l'IA vise à remédier à certains risques liés au fonctionnement des algorithmes. Outre ce texte, la Commission prévoit de prendre des initiatives ciblées dans des domaines spécifiques, tels que l'utilisation de l'IA et des algorithmes sur le lieu de travail. Elle envisage de s'inspirer des dispositions relatives à la gestion algorithmique contenues dans la proposition de directive relative aux travailleurs des plateformes.

La Commission européenne a également soumis pour adoption deux directives visant à établir un cadre horizontal de responsabilité pour les systèmes d'IA : une révision de la directive sur la responsabilité du fait des produits défectueux, et une directive sur la responsabilité en matière d'IA, qui partage le même objectif pour les règles de responsabilité non contractuelle fondées sur la responsabilité délictuelle. Tandis que le premier texte est sur le point d’être formellement adopté, les discussions sur le second s’ouvriront lors du prochain mandat du Parlement et de la Commission.

2. Résumé de l’Acte sur l’IA

I. Champ d’application et définitions

Le champ d'application de l’Acte sur l'IA est très large avec une forte portée extraterritoriale, puisqu’il s'appliquerait à tout système d'IA ayant un impact dans l'Union, quel que soit le lieu d'établissement du fournisseur. Plus précisément, l’Acte sur l'IA s'appliquerait lorsque le système d'IA est mis sur le marché ou mis en service dans l'Union, lorsqu'un utilisateur est situé dans l'Union ou lorsque le résultat est utilisé dans l'Union.

L'IA est définie en termes très larges. Elle couvre tout « système automatisé conçu pour fonctionner avec différents niveaux d'autonomie, qui peut faire preuve d’une capacité d’adaptation après son déploiement et qui, pour des objectifs explicites ou implicites, déduit, à partir des données d’entrée qu'il reçoit, la manière de générer des résultats tels que des prédictions, du contenu, des recommandations ou des décisions qui peuvent influencer des environnements physiques ou virtuels ».

L’Acte sur l'IA établit une distinction entre les systèmes d'IA traditionnelle et les modèles d'IA à usage général (GPAI), formés à l'aide d'un grand nombre de données, utilisant l'auto-supervision à grande échelle et capables d'exécuter efficacement un large éventail de tâches distinctes.

L’Acte sur l'IA prévoit plusieurs exceptions :

● Les systèmes et modèles d'IA développés et utilisés exclusivement à des fins militaires, de défense et de sécurité nationale.

● Les systèmes et modèles d'IA spécifiquement développés et mis en service à des fins exclusives de recherche scientifique et de développement.

● Toute activité de recherche, d'essai ou de développement concernant des systèmes ou modèles d'IA avant leur mise sur le marché ou leur mise en service.

● Les systèmes d'IA diffusés sous licence libre et open source (en français, « source ouverte »), sauf s'ils tombent sous le coup des interdictions et à l'exception des exigences de transparence pour les systèmes d'IA génératifs.

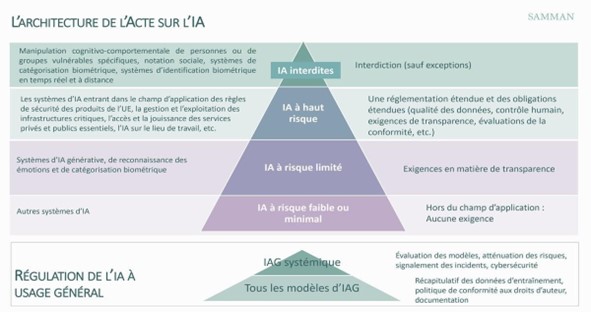

II. La réglementation : les systèmes d’IA interdits et à haut risque

L’Acte sur l'IA distingue quatre catégories de cas d'utilisation en fonction de leur niveau de risque pour la santé, la sécurité et les droits fondamentaux. Des exigences spécifiques s'appliquant aux fournisseurs et aux utilisateurs de ces systèmes sont attachées à chaque catégorie (voir schéma). Il règlemente également les modèles d'IA à usage général au travers de règles horizontales applicables à tous les fournisseurs modèles d'IA à usage général entrant dans le champ d'application de la réglementation, quel que soit leur niveau de risque.

a. Pratiques interdites en matière d’IA

L’Acte sur l'IA interdit la mise sur le marché, la mise en service ou l'utilisation des systèmes d’IA (avec des exceptions pour certains cas d'usage) :

- qui déploient des techniques subliminales, au-dessous du seuil de conscience d’une personne, ou des techniques délibérément manipulatrices ou trompeuses.

- qui exploitent les vulnérabilités d'une personne ou d'un groupe de personnes en raison de leur âge, d'un handicap ou d'une situation sociale ou économique spécifique.

- qui seraient à des fins de notation sociale ; d'identification biométrique à distance « en temps réel » dans des espaces accessibles au public à des fins répressives (mais avec des exceptions importantes).

- qui permettraient d'évaluer ou de prédire la probabilité pour une personne physique de commettre une infraction pénale.

- qui créent ou développent des bases de données de reconnaissance faciale par le moissonnage non ciblé d’images faciales provenant de l'internet ou de la vidéosurveillance; qui déduisent les émotions d'une personne physique dans des situations liées au lieu de travail et à l’enseignement, (avec plusieurs exceptions).

b. Les systèmes d’IA à haut risque

La réglementation des systèmes d'IA à haut risque constitue l'essentiel de l’Acte sur l'IA. Elle définit des règles pour la qualification des systèmes d'IA autorisés mais considérés comme à haut risque, les obligations et exigences auxquels ils sont soumis ainsi que les différentes parties de la chaîne de valeur, notamment les fournisseurs et les entités qui les déploient ou les intègrent dans leurs propres systèmes.

Qualification des systèmes d'IA à haut risque

Les systèmes d'IA à haut risque sont ceux qui ont un impact négatif significatif sur la santé, la sécurité, les droits fondamentaux, l'environnement, la démocratie et l'État de droit. Plus précisément, l’Acte sur l'IA établit deux catégories de systèmes d'IA à haut risque : les systèmes d'IA qui tombent sous le coup des règles européennes relatives à la sécurité des produits (jouets, voitures, santé, etc.), s'ils sont utilisés comme composants de sécurité d'un produit ou s'ils constituent eux-mêmes un produit (par exemple, application de l'IA à la chirurgie assistée par robot) ; et les systèmes d'IA énumérés dans une annexe au règlement. Cette annexe fournit une liste de cas d'utilisation et de domaines dans lesquels l'utilisation de l'IA est considérée comme présentant un haut risque. Elle peut être modifiée ou complétée par des actes délégués adoptés par la Commission européenne sur la base de certains critères.

En résumé, les domaines et les systèmes d'IA suivants sont concernés :

- Biométrie : systèmes d'identification biométrique à distance, certains systèmes de catégorisation biométrique, systèmes de reconnaissance des émotions.

- Infrastructures critiques : systèmes d'IA destinés à être utilisés en tant que composants de sécurité dans la gestion et l'exploitation d'infrastructures numériques critiques.

- Application de la loi, justice, immigration et processus démocratiques : gestion des migrations, de l'asile et des contrôles aux frontières ; administration de la justice et processus démocratiques.

- Éducation et lieu de travail : certains systèmes d'IA utilisés dans l'éducation et la formation professionnelle ; systèmes d'IA destinés à être utilisés pour le recrutement ou la sélection de candidats à un emploi ou pour prendre des décisions dans le cadre de la relation de travail ;

- Accès aux services essentiels : systèmes d'IA pour l'accès et la jouissance des services privés essentiels et des services et avantages publics essentiels.

- Application des lois, justice, immigration et processus démocratiques : gestion des migrations, de l'asile et des contrôles aux frontières ; administration de la justice et processus démocratiques.

L’Acte sur l'IA prévoit également la possibilité, pour les fournisseurs de systèmes d'IA à haut risque, de sortir de cette qualification en démontrant que leurs systèmes ne sont pas à haut risque en ce qu'ils n'influencent pas matériellement le résultat du processus de prise de décision. À cette fin, les fournisseurs doivent démontrer qu'ils remplissent au moins l'une des conditions suivantes :

- Le système d'IA est destiné à accomplir une tâche procédurale étroite.

- Il est destiné à améliorer le résultat d'une activité humaine préalablement réalisée.

- Il est destiné à détecter les modèles en matière de prise de décision ou les écarts par rapport à des modèles de prise de décision antérieurs et n'est pas destiné à remplacer ou à se substituer à l'évaluation humaine précédemment effectuée, sans un examen humain approprié.

- Il est destiné à effectuer une tâche préparatoire en vue d’une évaluation pertinente aux fins des cas d'utilisation énumérés à l'annexe III précitée.

Principales exigences applicables aux systèmes d'IA à haut risque et obligations des acteurs de la chaîne de valeur de l'IA

Les exigences pour les systèmes d'IA à haut risque sont les suivantes :

- Gestion des risques : mise en place d'un système de gestion des risques tout au long du cycle de vie du système d’IA.

- Gouvernance des données : formation du système avec des données et des ensembles de données qui répondent à certains critères de qualité.

- Documentation technique : rédaction d’une documentation technique démontrant la conformité avec l’Acte sur l'IA avant la mise sur le marché.

- Enregistrement : enregistrement automatique d'événements (« journaux ») pendant toute la durée de vie du système.

- Instructions d'utilisation : assurance que les utilisateurs puissent interpréter les résultats du système et l'utiliser de manière appropriée, notamment au moyen d'instructions détaillées.

- Contrôle humain : supervision efficace par des personnes physiques et assurée par un développement adéquat des systèmes.

- Exactitude, robustesse et cybersécurité : développement adéquat des systèmes assurant un niveau approprié d’exactitude, de robustesse et de cybersécurité.

L’Acte sur l'IA prévoit également une série d'obligations pour les différentes parties impliquées dans la chaîne de valeur (fournisseurs, importateurs, distributeurs et déployeurs), ainsi que des règles de détermination des responsabilités, notamment suite à une modification substantielle d’un système d'IA par l'une de ces parties.

Les obligations suivantes incombent ainsi aux fournisseurs des systèmes d’IA à haut risque :

- Conformité et enregistrement : l'obligation d'enregistrer leurs systèmes dans une base de données de l’Union spécifique et de rédiger la déclaration européenne de conformité.

- Système de gestion de la qualité : obligation de mettre en place un système de gestion de la qualité garantissant la conformité à l’Acte sur l'IA.

- Conservation des documents : obligation de tenir à la disposition des autorités nationales compétentes un ensemble de documents (documentation technique, historique avec les organismes notifiés, etc.)

- Journaux générés automatiquement : obligation de conserver les journaux générés automatiquement pendant une période adaptée à la finalité du système IA à haut risque, d’au moins six mois.

- Mesures correctives et devoir d'information : obligation de prendre des mesures immédiates en cas de non-respect de l’Acte sur l'IA et d'informer l'autorité de surveillance du marché.

Les autres acteurs de la chaîne de valeur sont principalement responsables de la conformité des systèmes d'IA qu'ils distribuent ou intègrent dans leurs propres services.

En outre, lorsque le déployeur est un organisme public ou un opérateur privé fournissant des services essentiels, il est tenu de procéder à une analyse d’impact sur les droits fondamentaux.

c. Systèmes d'IA à risque limité

Cette troisième catégorie s'applique aux fournisseurs et aux déployeurs de systèmes d'IA générative et aux systèmes de reconnaissance des émotions ou de catégorisation biométrique, qui doivent notamment se conformer aux exigences de transparence suivantes :

● Robots conversationnels (dialogueurs, chatbots) : informer les personnes physiques concernées qu'elles interagissent avec un système d'IA.

● IA générative : veiller à ce que les résultats soient marqués dans un format lisible par une machine et détectables comme étant générés ou manipulés artificiellement (filigrane).

● Hypertrucage (deepfakes) : étiqueter le contenu comme étant généré ou manipulé artificiellement ou informer les personnes lorsque le contenu fait partie d'une œuvre ou d'un programme manifestement artistique, créatif, satirique ou fictif.

Informations d'actualité : indiquer que le contenu a été généré ou manipulé artificiellement, à moins qu'il n'ait fait l'objet d'un examen humain ou d'un contrôle éditorial.

III. Réglementation de l'IA à usage général (GPAI)

L’Acte sur l'IA prévoit une réglementation à deux niveaux pour les modèles d’IA à usage général (ci- après, « GPAI »). Le premier niveau d'obligations s'applique à tous les modèles GPAI, tandis que le second niveau ne s'applique qu'aux modèles GPAI présentant des risques systémiques.

Dans les deux cas, la Commission conserve des pouvoirs importants sur la détermination des exigences. Elle pourra notamment s’impliquer dans l’élaboration de codes de pratique et de normes harmonisées de conformité sectorielles, avec les industriels et d'autres parties prenantes.

- Tous les modèles GPAI

L’Acte sur l'AIR impose les obligations suivantes aux fournisseurs de modèles GPAI, que leurs modèles soient ou non utilisés dans un domaine à haut risque :

● Établir et conserver la documentation technique (notamment le processus d’entraînement, d’essai et les résultats de l'évaluation).

● Fournir une documentation aux utilisateurs qui intègrent le modèle GPAI dans leurs propres systèmes d'IA (y compris des informations sur les limites et les capacités du modèle).

● Mettre en place une politique visant à respecter la législation en matière de droits d'auteur.

● Publier un résumé détaillé du contenu utilisé pour entraîner le modèle.

Les fournisseurs de modèles open source non systémiques sont exemptés des deux premières obligations. Il est à noter que la définition de l'open source est étroite, puisqu'elle ne concerne que les modèles « publiés sous une licence libre et ouverte permettant de consulter, d’utiliser, de modifier et de distribuer le modèle, et dont les paramètres, y compris les poids, les informations sur l’architecture du modèle et les informations sur l’utilisation du modèle, sont rendus publics ».

b. Exigences relatives aux modèles GPAI présentant des risques systémiques

L’Acte sur l'IA définit les modèles GPAI présentant des risques systémiques comme des modèles ayant des « capacités à fort impact » c'est-à-dire les modèles les plus performants et les plus puissants.

L’Acte sur l'IA qualifie tout modèle dont le volume cumulé de calcul utilisé pour son entraînement, mesuré en FLOPS (floating-point operations per second ou nombre d’opérations en virgule flottante par seconde) supérieur à 1025 comme présumé à « capacités à fort impact ». Le règlement réserve également une marge de manœuvre importante à la Commission pour s'appuyer sur d'autres critères et indicateurs afin de désigner un modèle comme présentant un risque systémique.

En plus de la première couche d'obligations, les fournisseurs de modèles GPAI présentant un risque systémique sont tenus :

- D'effectuer l'évaluation du modèle à l'aide de protocoles et d'outils normalisés.

- D'évaluer et atténuer les risques systémiques éventuels au niveau de l'Union.

- De signaler les incidents graves et les mesures correctrices à la Commission européenne et aux autorités nationales.

- D'assurer un niveau approprié de protection en matière de cybersécurité.

IV. Mesures de soutien à l’innovation

La principale mesure prévue par la Commission est la mise en place obligatoire d'au moins un « bac à sable » réglementaire de l'IA dans chaque État membre. Un « bac à sable » est un cadre mis en place par un régulateur qui permet aux entreprises, en particulier aux start-ups, de mener des expériences en direct avec leurs produits ou services dans un environnement contrôlé, sous la supervision du régulateur.

L’Acte sur l'IA établit des règles détaillées concernant la mise en place et le fonctionnement des bacs à sable réglementaires, y compris des règles sur le traitement ultérieur des données à caractère personnel pour le développement de certains systèmes d'IA d'utilité publique.

V. Gouvernance et sanctions

L’Acte sur l'IA établit un cadre de gouvernance très complexe et hybride, avec des pouvoirs de mise en œuvre et d'application répartis entre l'Union et les niveaux nationaux.

La Commission européenne jouera un rôle central dans la gouvernance et la mise en œuvre de l’Acte sur l'IA. Elle sera chargée de faire appliquer les dispositions relatives aux modèles GPAI, d'harmoniser l'application de l’Acte sur l'IA dans l'Union, de définir la conformité à l’Acte sur l'IA et de mettre à jour certains aspects essentiels de la réglementation. Au niveau national, les régulateurs seront chargés d'appliquer toutes les dispositions relatives aux pratiques d'IA interdites et à haut risque.

a Niveau européen

La Commission européenne a créé un Bureau de l’IA en charge de la mise en œuvre et de l'application de l’Acte sur l'AI. Il s’agit d’une nouvelle agence créée au sein de la Direction générale des réseaux de communication, du contenu et des technologies (DG CONNECT).

La Commission sera notamment chargée :

- D'appliquer toutes les dispositions relatives aux modèles GPAI : La Commission se voit attribuer de nouveaux pouvoirs à cette fin : demander des documents et des informations ; engager un dialogue structuré ; effectuer des évaluations ; exiger des mesures correctives ; ordonner le retrait ou le rappel du modèle ; accéder aux modèles GPAI présentant des risques systémiques par l'intermédiaire d'API, etc.

- D'adopter des actes délégués sur des aspects critiques de l’Acte sur l'IA, par exemple pour modifier la liste des systèmes d'IA à haut risque figurant à l'annexe III ou pour modifier les conditions de l'auto-évaluation du risque élevé.

- De publier des lignes directrices et élaborer des codes de conduite sur la mise en œuvre pratique de l’Acte sur l'IA.

La Commission sera soutenue par trois organes consultatifs :

- Le Comité européen de l’IA (ci-après, le « Comité ») : composée d'un représentant par État membre, avec la participation du Bureau de l’IA et du Contrôleur européen de la protection des données comme observateurs. Le Comité a pour objectif d’être une plateforme de coopération pour les autorités nationales dans les affaires transfrontalières. Il pourra également émettre des avis sur des instruments juridiques non contraignants, tels que les lignes directrices et les et les codes de conduite.

- Le Forum consultatif, composé d'experts de l'industrie, de la société civile et du monde universitaire, ainsi que de représentants de l'Agence de l’Union pour la cybersécurité (ENISA) et des principaux organismes de normalisation de l'Union.

- Le groupe scientifique d'experts indépendants (ci- après, le « groupe »), composé d'experts indépendants sélectionnés par la Commission. Ces experts conseilleront et soutiendront la Commission dans la mise en œuvre de l’Acte sur l'IA, en particulier sur les modèles GPAI. Ils pourront également accompagner le travail des autorités nationales à leur demande.

b Niveau national

Les États membres devront désigner une autorité réglementaire indépendante agissant en tant qu'autorité de surveillance du marché responsable de l'application de l’Acte sur l'IA au niveau national.

Cette autorité de surveillance du marché sera désignée conformément au règlement (UE) 2019/1020, qui encadre la surveillance du marché et la conformité des produits dans l'Union pour un large éventail de produits. Ce règlement confère d'importants pouvoirs d'exécution aux autorités nationales, tels que le pouvoir d'effectuer des contrôles sur les produits, de demander et d'obtenir l'accès à toute information relative au produit, d'exiger des mesures correctives ou d'imposer des sanctions. En vertu de l’Acte sur l'IA, l'autorité nationale de surveillance du marché disposera de pouvoirs supplémentaires, comme celui de demander l'accès au code source ou de contrôler l'auto-évaluation de risques élevés.

L’Acte sur l'IA prévoit également l'implication des autorités chargées de la protection des droits fondamentaux et des régulateurs sectoriels dans les domaines relevant de leur propre compétence, tels que les régulateurs financiers et les autorités chargées de la protection des données.

Enfin, les États membres devront désigner au moins une autorité chargée de la notification, et chargée de mettre en place et d'exécuter les procédures nécessaires à la désignation et à la notification des organismes d'évaluation de la conformité.

c Sanctions financières

Au-delà des mesures correctives, les autorités nationales et la Commission auront un pouvoir de sanctions sous forme d’amendes, dont le montant dépendra de la nature des infractions :

- Non-respect des pratiques interdites en matière d'IA : amendes administratives pouvant atteindre 35 millions € ou 7 % du chiffre d'affaires annuel mondial total, le montant le plus élevé étant retenu.

- Non-respect d'autres dispositions : amendes administratives pouvant atteindre 15 millions € ou 3 % du chiffre d'affaires annuel mondial total, le montant le plus élevé étant retenu.

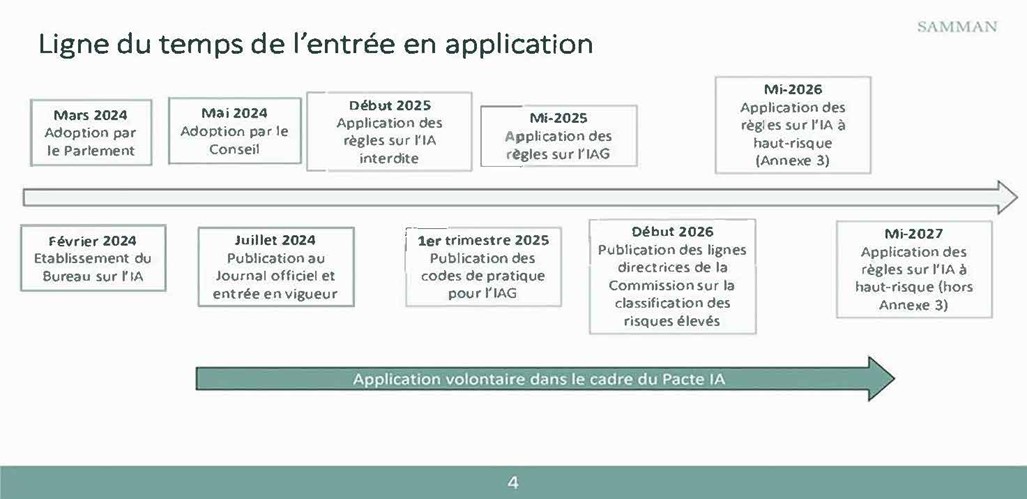

VI. Calendrier de mise en œuvre

L’Acte sur l'IA, publié au Journal officiel de l'Union le 12 juillet 2024, entrera en vigueur 20 jours après et sera applicable à partir du 2 août 2026.

- Les règles relatives aux pratiques interdites en matière d'IA s'appliqueront six mois après son entrée en vigueur (janvier 2025).

- Les codes de pratique pour les modèles GPAI devraient être publiés, au plus tard, par la Commission, neuf mois après son entrée en vigueur (1er trimestre 2025).

- Les règles concernant les modèles GPAI s'appliqueront douze mois après son entrée en vigueur (août 2025). Ce sera aussi la date limite pour la désignation des autorités nationales de surveillance du marché et la publication de certaines lignes directrices sur les systèmes d'IA à haut risque par la Commission.

- La Commission devra publier des lignes directrices sur la classification des systèmes d'IA à haut risque au plus tard dix-huit mois après son entrée en vigueur (début 2026).

- Les règles concernant les systèmes d'IA à haut risque énumérés à l'annexe III s'appliqueront vingt-quatre mois après son entrée en vigueur (août 2026).

- Les règles concernant les autres systèmes d'IA à haut risque s'appliqueront trente-six mois après son entrée en vigueur (été 2027).

***

L’Acte sur l’intelligence artificielle constitue la nouvelle pierre angulaire de l’édifice juridique de l'Union européenne en matière d'IA mais son accueil semble mitigé. Son architecture simple est trompeuse : son régime réglementaire et sa structure de gouvernance sont complexes car son application est répartie entre l'Union et les États membres. La Commission européenne jouera un rôle central dans la mise en œuvre de ce texte et l’harmonisation, dès 2025. Enfin, on peut regretter que cet Acte sur l'IA ne promeuve pas davantage ses mesures élaborées dans le but de protéger l'innovation, essentiellement au travers de bacs à sable réglementaires, du fait des enjeux en matière de protection des droits fondamentaux.

Directeur de la publication : Pascale Joannin

Sur le même thème

Pour aller plus loin

Agriculture

Bernard Bourget

—

16 février 2026

Identités européennes

Patrice Cardot

—

9 février 2026

L'UE dans la mondialisation

Olena Oliinyk

—

2 février 2026

Stratégie, sécurité et défense

Jean Mafart

—

26 janvier 2026

La Lettre

Schuman

L'actualité européenne de la semaine

Unique en son genre, avec ses 200 000 abonnées et ses éditions en 6 langues (français, anglais, allemand, espagnol, polonais et ukrainien), elle apporte jusqu'à vous, depuis 15 ans, un condensé de l'actualité européenne, plus nécessaire aujourd'hui que jamais

Versions :